【用途別で考える】ローカルLLMサーバのGPU選定ガイド

1. ローカルLLMとは?

LLMとは?

LLMとは「大規模言語モデル(Large Language Model)」の略で、ChatGPTやClaudeのようなAIを指します。大量のテキストデータをもとに学習され、人間に近い自然な会話、要約、分類、文章生成などを行えるのが特徴です。

代表的なLLM例:

LLaMA、Mistral、Gemma、Falcon など

パラメータ数で分類される(例:7B=70億パラメータ、13B=130億パラメータ

なぜ“ローカル”で運用するのか?

クラウド型のLLM(ChatGPT等)も手軽ですが、以下のような理由からローカルで運用するニーズが高まっています:

セキュリティ重視(機密情報をクラウドに出せない)

応答速度を短縮したい

長期的なコスト圧縮

カスタマイズ性の確保(自社独自の学習が可能)

その中心となるのが GPUサーバ です。

特に、モデルのサイズ(7B、13B、70Bなど)に応じて、必要なGPU性能・メモリ量(VRAM) が大きく異なります。

一方で、どのGPUを選定すべきか分かりにくいのが実情です。

本稿では、ローカルLLM運用に最適なGPUを、用途ごとに整理し、選定のポイントとあわせて紹介します。

※コンシューマ向けであるGeforce及びAMD Radeon/Instinctは除外しています。

NVIDIA搭載 LLM AI向け 高出力サーバー

2. GPU選定の基本

GPUの役割とは?

LLMの処理には並列演算が必要不可欠であり、CPUではとても処理しきれません。

そのため、大量の浮動小数点計算(FP16/FP32演算)を得意とするGPU が必須になります。

用語解説

| 用語 | 意味 |

|---|---|

| B(Billion) | パラメータ数を示す単位(7B=70億個) |

| VRAM | GPUに搭載されたメモリ。モデルを保持・実行するのに使う |

| FP16/TFLOPS | 浮動小数点計算性能(数値が大きいほど高速) |

| HBM3 / GDDR6 | GPU用メモリの種類。HBMは高帯域・高価格、GDDRは一般的 |

| NVLink | GPU同士を高速でつなぐためのNVIDIA独自技術 |

3. 用途別:おすすめGPU早見表

| 用途 | 推奨GPU | 備考 |

|---|---|---|

| 7Bモデルの推論のみ | RTX 5000 Ada / L40S | 単体利用なら32〜48GB VRAMあれば安定 |

| 13Bまでの推論 | RTX 6000 Ada / L40S | 消費電力と性能のバランスが良い |

| 13Bの軽量ファインチューニング | RTX 6000 Ada(複数枚) / L40S(複数枚) | QLoRAやAWQで効率的に動作 |

| 70B以上の推論 | H100 / H200(4枚以上) | 計算性能だけでなくメモリ帯域が鍵 |

| SFTやRLHF学習 | H100 / H200 | 高速なFP8演算と広帯域メモリが重要 |

| 画像生成(SDXL等) | L40S / RTX 6000 Ada | FP16以上の精度でも高速 |

4. GPUごとの特長と選び方

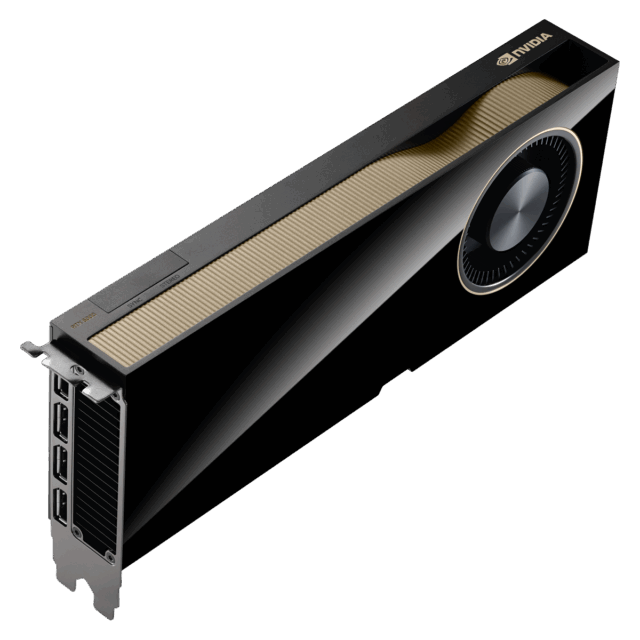

NVIDIA RTX 5000 Ada(32GB GDDR6 ECC)

VRAM:32GB

FP8性能:約190 TFLOPS(理論値)

アーキテクチャ:Ada Lovelace

TDP:250W

おすすめ用途:

- 7Bクラスの推論

- QLoRAを用いた超軽量なファインチューニング

補足:

GDDR6メモリ搭載で、消費電力と性能のバランスが良好。ミッドレンジ帯ながら24GBを超えるVRAMを持ち、推論用途に広く対応。データセンター未満の開発環境でも扱いやすい1枚。

RTX 5000 Ada搭載モデル

xFusion FusionServer 2288H V6

GPU搭載 LLM汎用サーバー / nvidia RTX 5000ADA 32GB 1台 / 18コアXeon Gold 6354 3GHz 2CPU / メモリ256GB / 960GB SSD / 10Gb-Tx2 / 25Gb x2 / 2000W*2 / 訪問修理

2,472,800円(税込)

HP 94B91PA#ABJ Z4 Rack G5

Windows 11 インストール済 / 16コア Xeon W5-2465X 3.1GHz / 64GB / 2TB ZT / RTX 5000 ADA 32GB

657,800円(税込)

NVIDIA RTX 6000 Ada(48GB GDDR6 ECC)

VRAM:48GB

FP8性能:約380 TFLOPS(理論値)

アーキテクチャ:Ada Lovelace

TDP:300W

おすすめ用途:

- 13Bまでの推論

- 軽量な学習用途

- 複数枚でのQLoRAにも活用可

補足:

Ada世代のフラッグシップGPU。前世代のA6000から大幅に演算性能が向上しており、H100が過剰なケースにおいて最適解となる。NVLinkは非対応だが、単体でのパフォーマンスは非常に高い。

RTX 6000 Ada搭載モデル

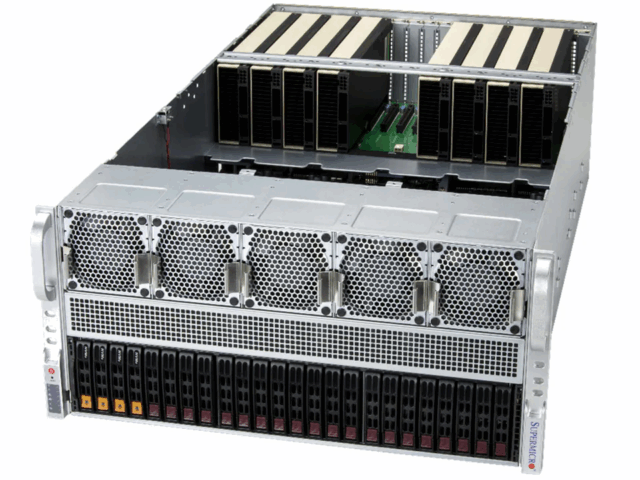

SuperMicro AS-4125GS-TNRT

NVIDIA RTX6000ADA 48GB 4台搭載済み / AMD EPYC 9374F 3.85GHz 32C 2CPU / 512GB / 3.84TB NVMe

10,670,000円(税込)

xFusion FusionServer 2288H V6

GPU搭載 LLM汎用サーバー / nvidia RTX 6000ADA 48GB / 18コアXeon Gold 6354 3GHz 2CPU / メモリ256GB / 960GB SSD / 1000Tx4 / 25Gb x2 / 2000W*2 / 訪問修理

3,077,800円(税込)

xFusion FusionServer 2288H V6

商品説明分が入ります。商品説明分が入ります。商品説明分が入ります。商品説明分が入ります。

3,935,800円(税込)

NVIDIA L40S(48GB GDDR6)

- アーキテクチャ:Ada Lovelace(RTX 4090系に近いが商用)

- AI推論性能(INT8):1200 TOPS超

- 消費電力:300W

おすすめ用途:

- 推論処理全般(Mistral, LLaMA2-13B 等)

- 軽量LoRA学習

補足:

DL専用エンジン(Tensor Core)やハードウェアレイトレーシングも搭載。商用向けでサーバGPUとして使える珍しいAda世代。

L40S搭載モデル

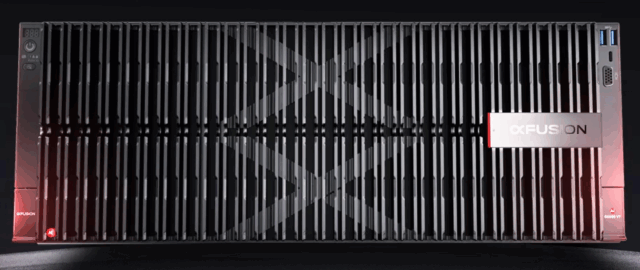

xFusion FusionServer 2288H V7

NVIDIA GPU L40S 2台搭載可能シャーシ!24コアXeon Gold 6542Y 2.9GHz 2CPU / 256GB / NVMe 1.92TB / 2000W*2 / 3年間訪問修理(GPUは除く)

6,150,870円(税込)

xFusion FusionServer G5500 V7

GPU搭載モンスターサーバ / nvidia L20 48GB 8台 / 32コアXeon Gold 6530 2.1GHz 2CPU / メモリ512GB / SSD 480GB x2 /3.84TB NVMe / 10Gbx2 / 25Gbx2 SFP28 / 2000W*4 / 3年訪問修理!

14,278,000円(税込)

xFusion FusionServer G5500 V7

GPU搭載モンスターサーバ / nvidia L40S 48GB 8台 / 32コアXeon Gold 6530 2.1GHz 2CPU / メモリ512GB / SSD 480GB x2 / 3.84TB NVMe / 10Gbx2 / 25Gbx2 SFP28 / 2000W*4 / 3年訪問修理!

16,478,000円(税込)

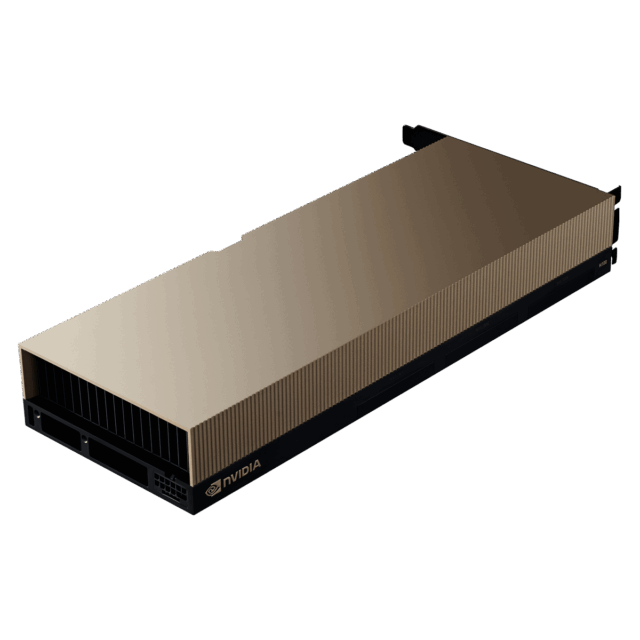

NVIDIA H100(80GB HBM3)

- アーキテクチャ:Hopper

- FP16:> 60 TFLOPS(SXMモードで圧倒的性能)

- 通常はSXM or PCIe版で提供

おすすめ用途:

- 13B以上のLoRA、RLHFなどの学習

- 70B級モデルの分散推論(複数台構成)

補足:

HBM3メモリ搭載で圧倒的な帯域(>2TB/s)、SXM構成ならNVLinkで多GPU連携も可能。電力や冷却に注意が必要。

NVIDIA H200(141GB HBM3e)

- 2024年登場の最新モデル

- H100の後継。HBM3eにより帯域さらに向上

- データセット全体をVRAM内に持たせることも可能に

おすすめ用途:

- 70B以上の学習・推論(分散前提)

- 膨大なデータ処理が必要な法人向け、研究用途

補足:

価格も非常に高額(5百万円〜)だが、今後の生成AIアプリケーションを本格的に運用する企業には必須クラス。

オット君

オット君番外編:L4について

L4は低消費電力GPU(80W)で、推論専用に設計されています。

・INT8推論向け

・VRAMは24GB

・静音・省電力設計なのでエッジAI用途に最適

ただし、LoRAや学習には不向きです。

H200搭載モデル

SuperMicro AS-5126GS-TNRT

H200 NVL 141GB 2台搭載済み / AMD EPYC 9375F 3.85GHz 32C 2CPU / 1024GB / 7.68TB NVMe

17,380,000円(税込)

5. GPU選定時の注意点

- モデルサイズとVRAMは比例する

7Bモデルなら約16〜24GB、13Bモデルは40〜50GB以上が必要。65B以上の超大規模モデルは分散メモリ構成が必須になる。 - 演算性能(TFLOPS, TOPS)も重要

特に学習や同時多重推論の際に処理速度に直結するため無視できない。 - 冷却と電源要件を見落とさない

H100やH200は空冷不可のケースも多く、ラックやサーバー筐体の選定が重要になる。 - 将来の拡張性(スケーラビリティ)を考慮

PCIeスロット数、電源容量、NVLinkなどマルチGPU連携の対応も要検討。

6. まとめ:GPU選定は「用途ありき」

ローカルLLMサーバを構築する上で、GPUの選定は「大は小を兼ねる」ではありません。

確かにH100やH200は非常に強力ですが、コスト・発熱・消費電力を考えると現実的ではない場面も多くあります。

「何をしたいか(推論だけか、学習も行うか)」「どこまでのモデルを使いたいか(7Bか13Bか70Bか)」によって、RTX 5000 Ada・6000 Ada・L40S・H100/H200など、ベストな選択肢は変わってきます。

また、最近の量子化技術(AWQやGPTQ、QLoRA)により、GPUに求められるメモリ容量や演算性能も変化してきています。

ファインチューニング(LoRAなど)まで視野に入れるかどうかで、GPUの枚数構成まで変わってきます。

まずは「どんな規模で、どこまでやりたいか」を明確にした上で、コストと性能のバランスが取れたGPUを選ぶのが成功の秘訣です。

こんな方におすすめGPUまとめ(簡易)

まず7Bモデルをローカルで動かしてみたい方

→ RTX 5000 Ada … 消費電力も低く、1枚で完結しやすい

13Bを安定して使いたい/小規模なファインチューニングもしたい方

→ RTX 6000 Ada or L40S … VRAM 48GBの恩恵が大きい

Stable Diffusion や 画像生成もやりたい方

→ L40S … 高速レンダリングに強く、FP16性能も十分

70Bモデルも想定している/将来拡張したい方

→ H100 or H200(複数枚) … メモリ帯域と拡張性が重要

あとがき

ローカルLLMは、2025年現在、クラウドに依存しないAI戦略の中核として注目されています。

GPU選定はその第一歩。

あなたの目的に合ったGPUを選び、理想のAI基盤構築を進めてみてください。

▼弊社GPU搭載サーバーページはコチラから!