Proxmox VEは企業インフラに使えるのか?〜ネットワーク障害編〜

はじめに

過去2回にわたり「Proxmox VEは企業インフラに使えるのか?」というテーマで、ノード障害やディスク障害に関する検証記事を公開しました。

今回取り上げるのは、Proxmox VEのHCI構成で特に重要な要素であるネットワーク障害です。

HCI環境におけるネットワークは、システム全体の安定性や可用性を左右する基盤であり、仮想マシンの通信、管理アクセス、クラスタ内のデータ同期など多岐にわたって利用されます。そのため、障害発生時にどのような挙動を示すかを事前に把握しておくことは、運用設計上欠かせません。

本記事では、3つのシナリオを想定し、それぞれのネットワーク障害時におけるProxmox環境の動作を検証した結果をご紹介します。

Proxmox VEに関する説明はこちらの記事をご覧ください。

脱VMwareの大本命!“Proxmox VE“に仮想マシンをマイグレーションしてみた。

障害検証のアーカイブ記事はこちらからご覧ください。

Proxmox VEは企業インフラに使えるのか?〜ノード障害編〜

Proxmox VEは企業インフラに使えるのか?〜ディスク障害編〜

検証環境

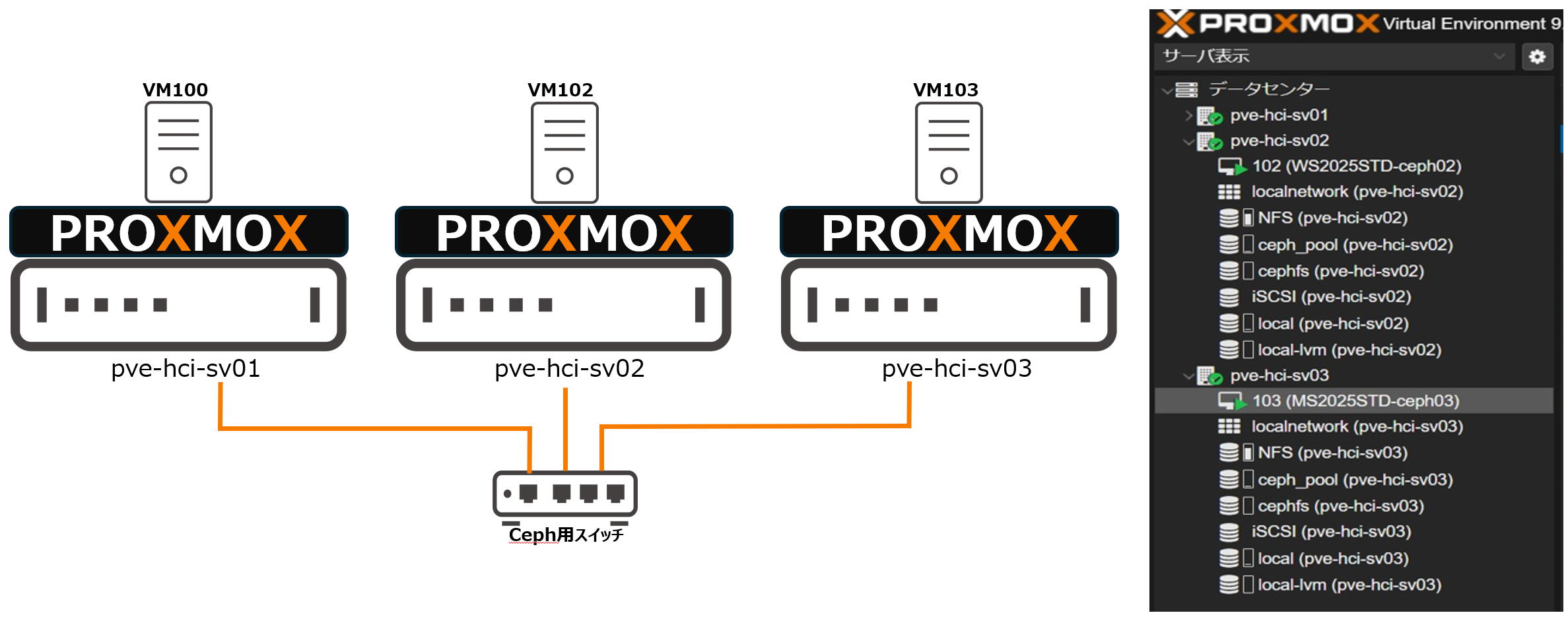

構成

- Proxmox VE バージョン:9.0.9

- ノード数:3ノード構成(pve-hci-sv01 / pve-hci-sv02 /pve-hci-sv03)

- 構成:CephによるHCI(ハイパーコンバージドインフラ)構成

- HWスペック(1ノードあたり):Intel(R) Xeon(R) CPU E3-1230 v6、64GB、SATA HDD x1(OS領域)、SATA HDDx1(Ceph領域)、1000BASE-T

ネットワーク障害の検証内容

①仮想マシン用ネットワーク通信障害時の動作検証

②管理用ネットワーク障害時の動作検証

③HCIデータ交換用ネットワーク通信障害時の動作検証

※いずれも単一NICでの動作検証

検証結果

①仮想マシン用ネットワーク通信障害時の動作検証

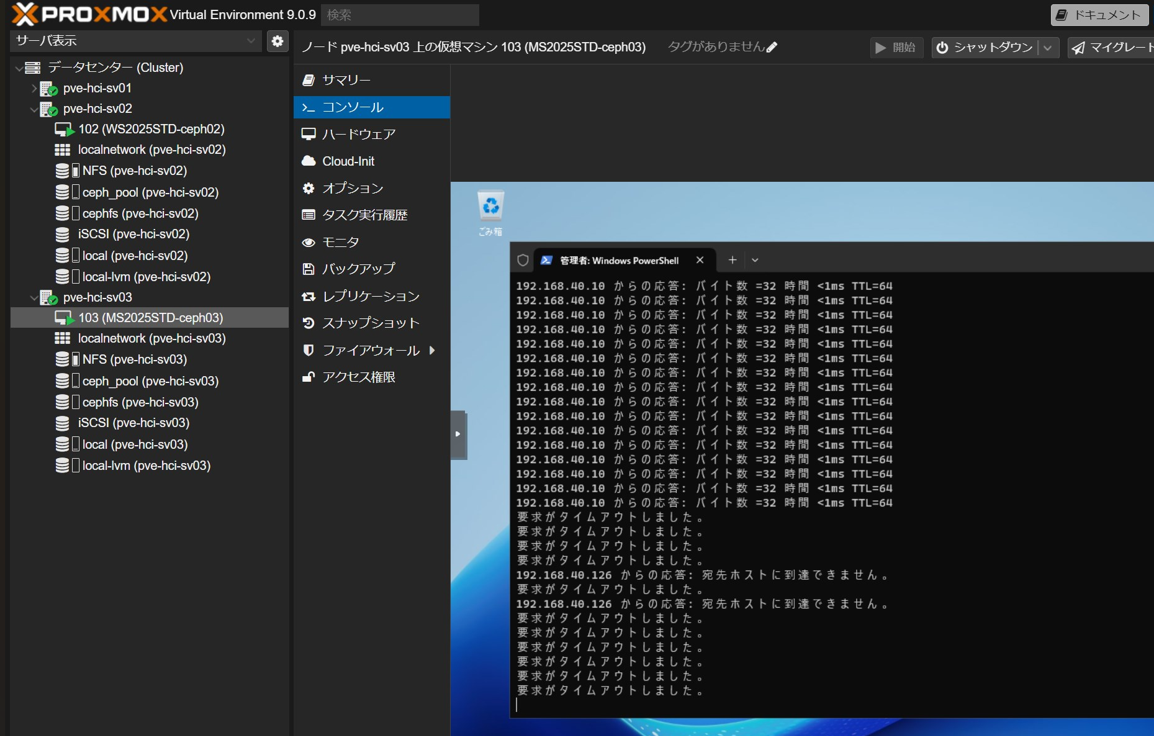

Proxmox VE ホストノード3(pve-hci-sv03)の仮想マシン用NIC(単一)に接続されたLANケーブルを抜線し、疑似的に障害を発生させました。

NIC障害が発生すると同時に仮想マシンの外部通信は途絶し、サービス提供は即座に停止。ログにも通信断が記録されました。

なお、この障害ではフェイルオーバーは実行されず、仮想マシンはノード3(pve-hci-sv03)上に留まったままです。

■結果

仮想マシンの通信は完全に遮断されましたが、別ノードへの自動フェイルオーバーは発生しませんでした。

つまり、「仮想マシン用ネットワーク障害=HCI HAの対象外」 であり、通信断は検知されてもノード障害とは判定されないため、Proxmox HAは動作しないことが確認できました。

本番運用においては、NICをボンディング(Bond)構成で冗長化し、単一NIC障害によるサービス停止を回避する設計が必要と考えられます。

②管理用ネットワーク障害時の動作検証

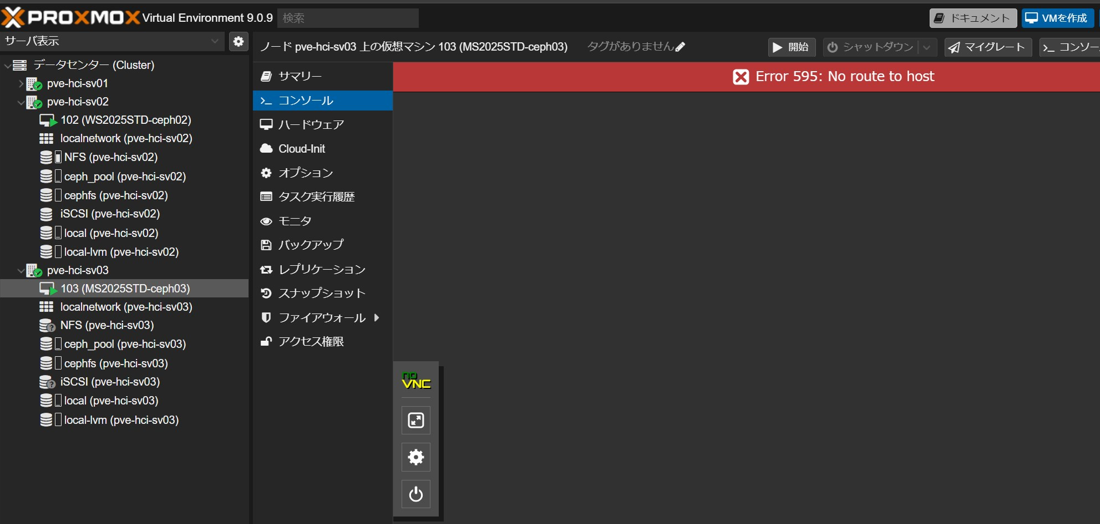

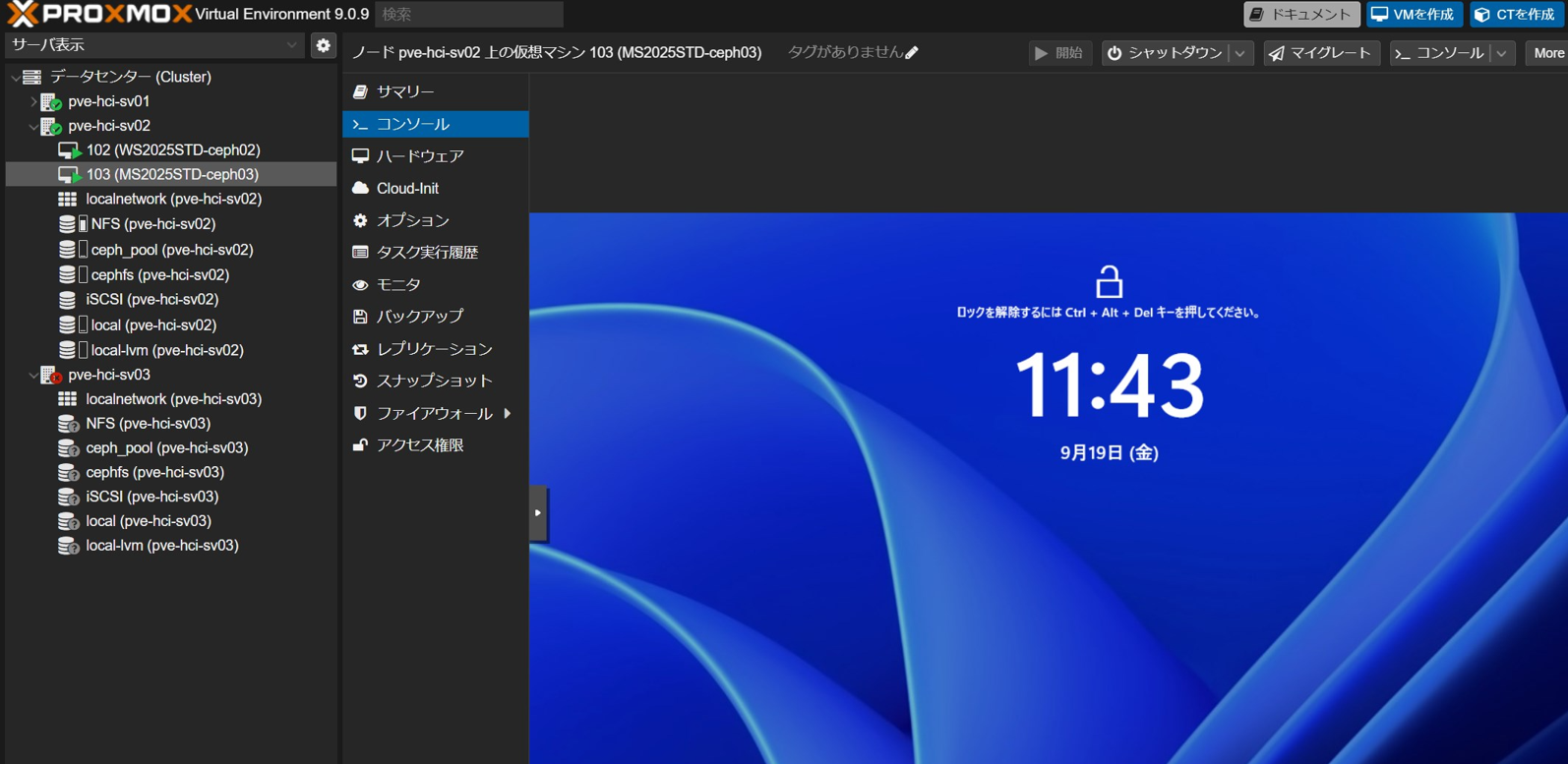

続いてProxmox VE ホストノード3(pve-hci-sv03)の管理用NIC(単一)に接続されたLANケーブルを抜線し、疑似的に障害を発生させました。

NIC障害が発生した瞬間にProxmox VE ホストノード3(pve-hci-sv03)の管理画面へのアクセスができなくなりました。

別ノードの管理画面から、Proxmox VE ホストノード3(pve-hci-sv03)で稼働している仮想マシンのコンソールに接続しようとしてもエラーになります。

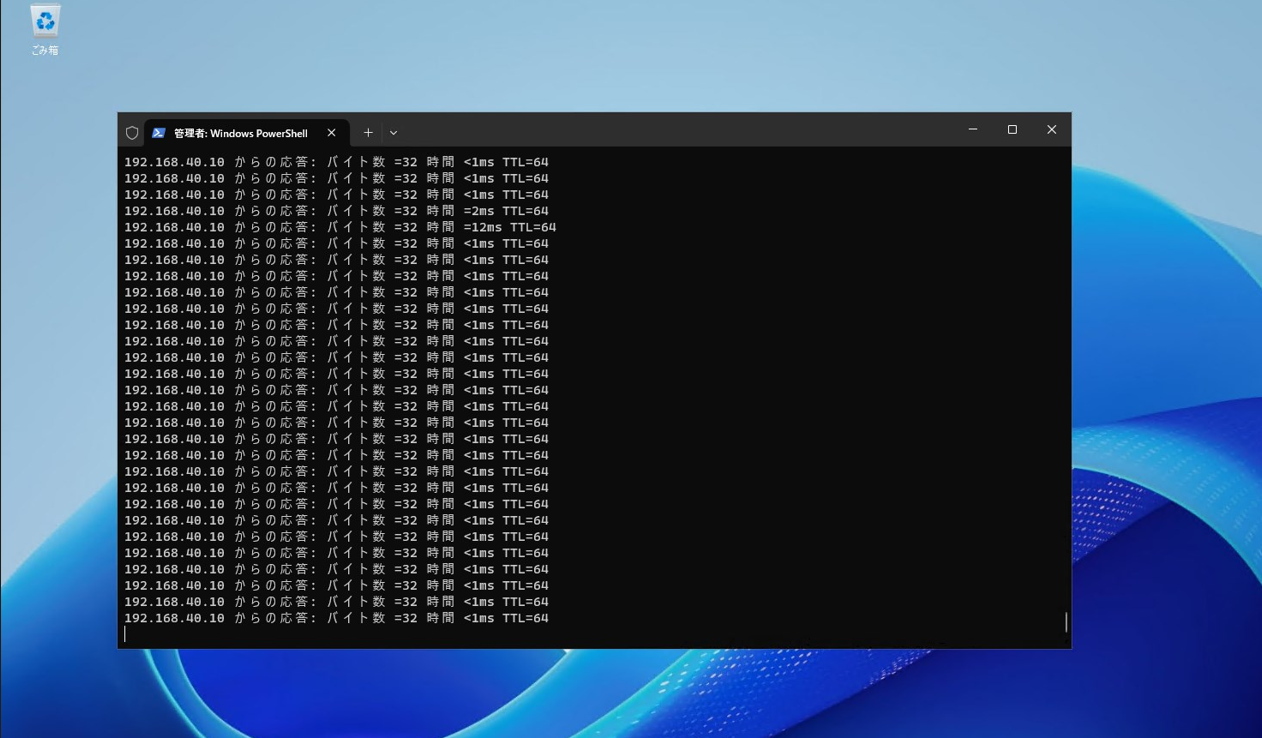

一方でProxmox VE ホストノード3(pve-hci-sv03)で稼働している仮想マシンにリモートデスクトップで接続して確認すると、問題なく稼働していることが確認できました。

■結果

管理用NICに障害が発生した場合、当該ノード(Proxmox VE ホストノード3: pve-hci-sv03)および別ノードからも、その管理画面へアクセスできなくなりました。

一方で、当該ノード上で稼働している仮想マシン(VM103)の動作には影響がなく、サービス提供は継続されました。

仮想マシン用NICの通信障害時と同様に、管理用NIC障害に対してもフェイルオーバーは実行されないため、管理ネットワークはHCI HAの対象外であることが確認できました。

本番運用においては、専用の冗長ネットワークまたはiLO/iDRAC/IBMCといった帯域外管理の併用が必要であると考えられます。

③HCIデータ交換用ネットワーク通信障害時の動作検証

最後にProxmox VE ホストノード3(pve-hci-sv03)のHCIデータ交換用NIC(単一)に接続されたLANケーブルを抜線し、疑似的に障害を発生させました。

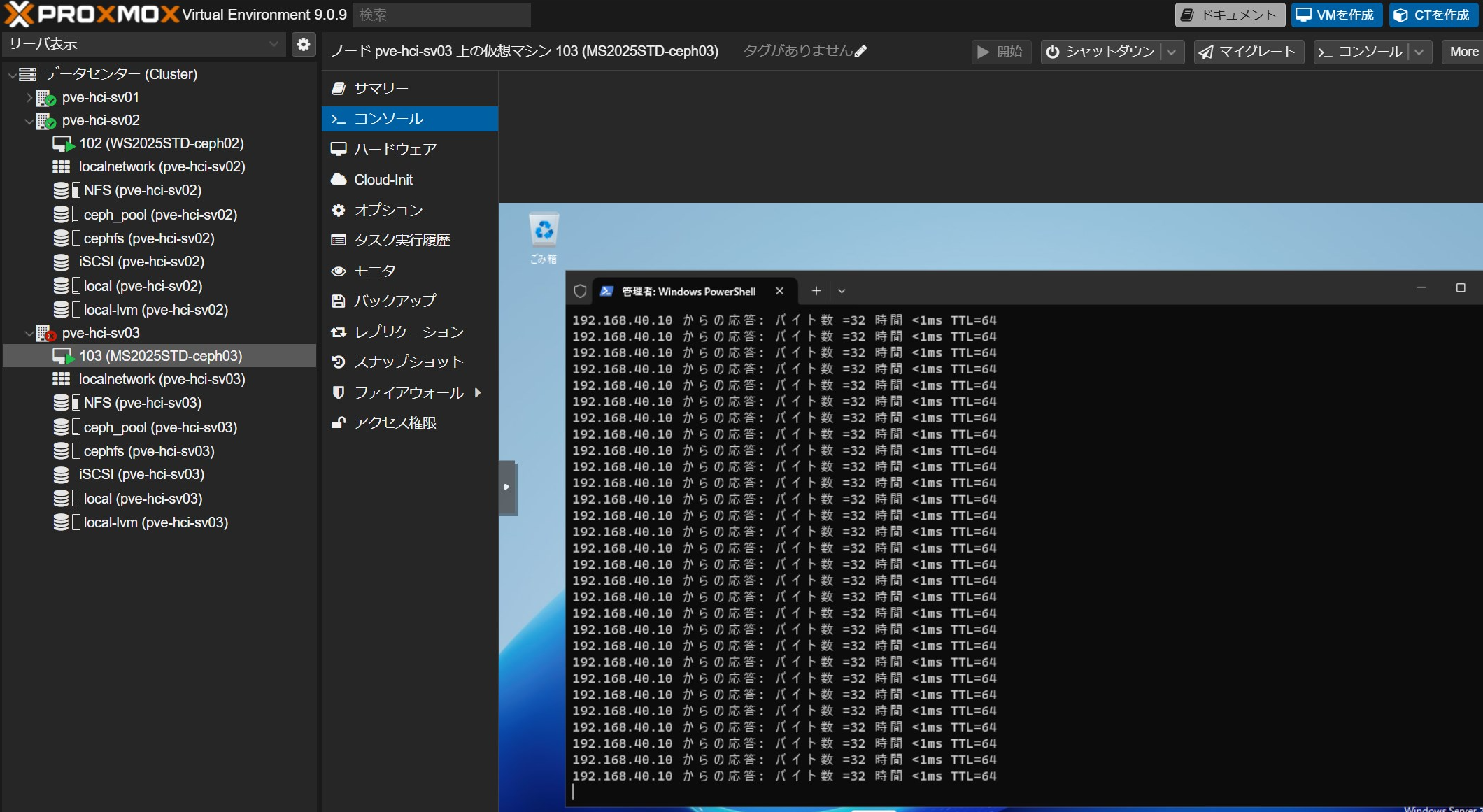

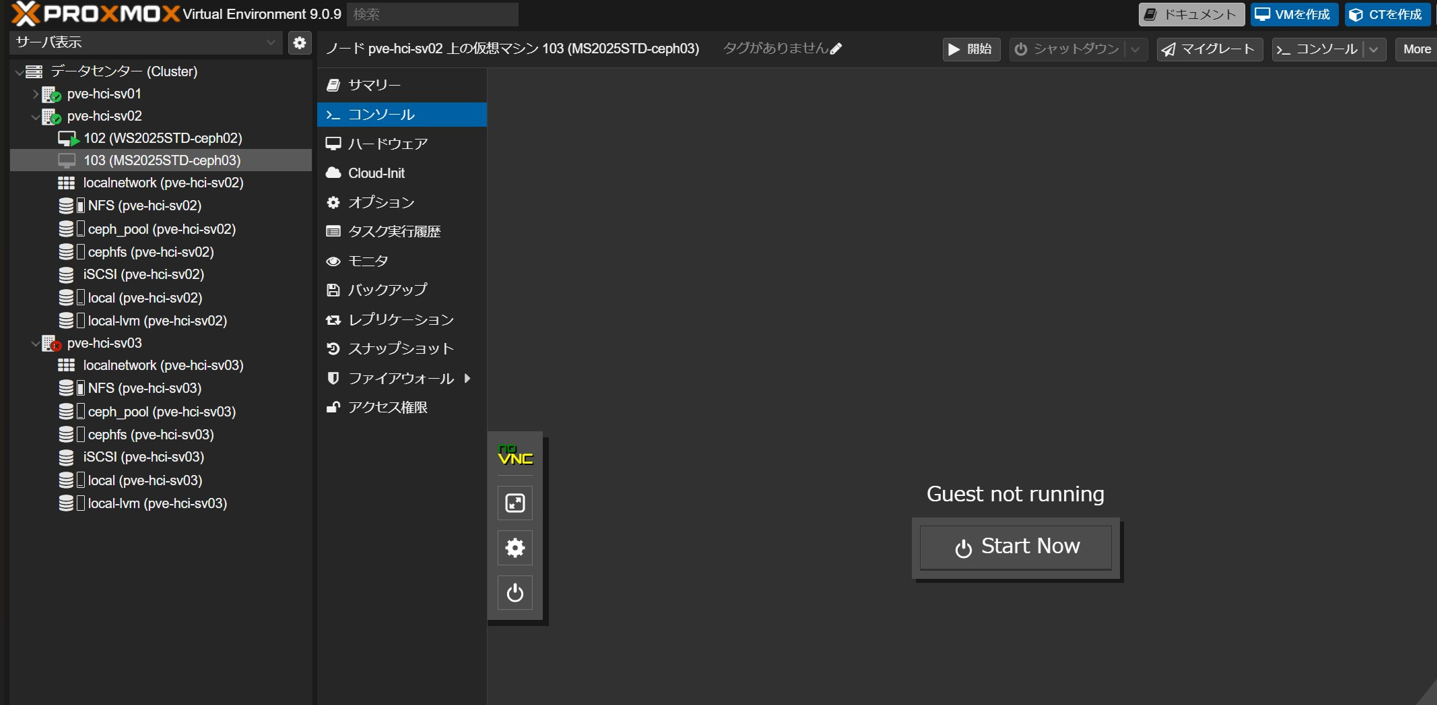

仮想マシンの通信が遮断され、再起動を伴うフェイルオーバーが実行されました。

通信遮断から約2分後(※当社環境での時間)に、稼働マシンが他ノードに移動しました。

仮想マシンが他ノードに移動してから、1分後(※当社環境での時間)に起動しました。

■結果

Proxmox VE ホストノード3(pve-hci-sv03)がクラスタから切り離され、その上で稼働していた仮想マシンへの通信が途絶しました。これに伴い、再起動を伴うフェイルオーバーが実行され、仮想マシン(VM103)は他ノード上で再起動・稼働を継続しました。

ノード復旧後には Ceph クラスタにて再同期処理が行われ、その間はクラスタ全体のディスク I/O 性能が一時的に低下することが確認されました。

HCIデータ交換ネットワークはクラスタ可用性に直結するクリティカルな要素であり、冗長構成の確保や物理的なスイッチ二重化が必要であると考えられます。

おわりに

いかがでしたでしょうか。

今回の検証では、Proxmox VE における HCI 環境において、仮想マシン用ネットワーク障害・管理用ネットワーク障害・HCI データ交換ネットワーク障害が発生した際の挙動を確認しました。

- 仮想マシン用NICの障害では仮想マシンの通信が途絶するものの、HA フェイルオーバーは実行されない。

- 管理用NICの障害でもノード管理は不能になるが、HA フェイルオーバーは実行されないが、仮想マシンは継続稼働する。

- HCIデータ交換用NICの障害ではHA フェイルオーバーが実行され、仮想マシンは他ノードで継続稼働する。

これらの結果から、ネットワーク冗長化の設計は 仮想マシンの可用性・クラスタ全体の安定稼働に不可欠であることが分かりました。

当社ではこれまでの実績と蓄積したナレッジをもとに、商用サブスクリプションの販売はもちろん、サーバー選定・構築・移行作業までワンストップで対応しております。

仮想環境の見直しや移行をご検討中の方は、どうぞお気軽に当社までご相談ください。

※記載されている製品名・会社名は、各社の登録商標または商標です。

■お問合せ先

KSG株式会社 SS営業部

メールアドレス:ss@ksgnet.com

電話番号:03-3233-8002

関連記事

・脱VMwareの大本命!“Proxmox VE“に仮想マシンをマイグレーションしてみた。

・VeeamでProxmox VEのバックアップを取ってみよう!

・Proxmox VEは企業インフラに使えるのか?〜ノード障害編〜

・Proxmox VEは企業インフラに使えるのか?〜ディスク障害編〜