AI開発界隈で話題の「DGX Spark」とは?──省スペースで本格LLMが動かせる新型ワークステーション

AI開発界隈でじわじわ注目を集めている、NVIDIAの新型ワークステーション「DGX Spark」。

発表から少し時間が経ちましたが、その中身を改めてチェックしてみると、かなり面白いポテンシャルを秘めています。

一言でいうなら「データセンター級のパワーを、机の横に置けるサイズにまとめた一台」。

本格的なAIワークロードをオンプレミスで、しかもコンパクトに実現したい企業や研究機関にとって、注目の選択肢となりそうです。

弊社でも現在、このDGX Sparkの取り扱いを予定しており、販売スケジュールや価格は現在調整中です。

先行して概要と魅力をご紹介いたします。

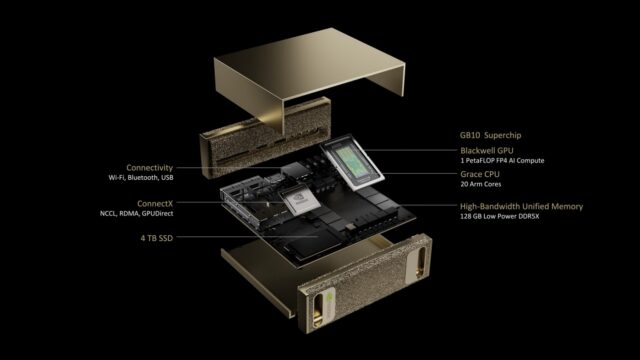

製品スペック(ハイライト)

| 項目 | 内容 |

|---|---|

| GPU | Blackwellアーキテクチャ(第5世代Tensorコア) FP4演算対応/NVENC・NVDEC搭載 |

| AI性能 | 最大 1 PFLOP(FP4/sparse時) |

| CPU | NVIDIA Grace(20コア:高性能×10 + 省電力×10) |

| メモリ | 128GB LPDDR5X(CPU/GPU共有) |

| ストレージ | 1TB または 4TB NVMe SSD(自己暗号化対応) |

| ネットワーク | 10GbE(有線LAN) ConnectX-7 SmartNIC(200GbE) Wi-Fi 7 / Bluetooth 5.3 |

| 映像出力 | HDMI 2.1a(音声出力対応) |

| USBポート | USB4(Type-C)×4 |

| OS | NVIDIA DGX OS(Ubuntuベース+AI開発スタックプリインストール) |

| サイズ | 150 × 150 × 50.5 mm |

| 重量 | 約1.2kg |

このスペックは、正直なところ小型ワークステーションの枠を完全に超えており、むしろ「AI開発・推論をデスクトップで可能にする超小型スパコン」と呼ぶべきかもしれません。

単体で最大2,000億パラメータ規模の大規模言語モデルにも対応可能で、クラスタ構成を組まずとも、高効率なAI推論やファインチューニングが行えます。

想定される利用シーン

DGX Sparkは「クラウドじゃなくてもAIが回せる」という選択肢を提示してくれる製品です。

以下のような用途を想定すると、かなり理にかなっています。

- 自社の社内データを使ったRAG(検索拡張生成)のベースモデル運用

- セキュリティ要件により外部クラウド利用が難しい企業のオンプレAI開発

- 生成AI、画像/動画系AIのローカル実験環境

- 教育機関・研究機関におけるLLMやマルチモーダルAIのトレーニング

特に近年は「まず社内で一部検証したい」「コスト的にクラウドGPUが使いにくい」という声も多く、そうした“ちょうどいい現場導入モデル”として光る存在です。

まとめ

DGX Sparkは、“AIをローカルで完結させる”というニーズに応える、これまでにない設計思想を持ったワークステーションです。

AI開発の即応性・独立性を重視する現場において、デスクトップサイズの本格GPU基盤は、新たな選択肢となることでしょう。

今後の販売スケジュールや価格情報については、情報が入り次第随時お知らせいたします。

引き続きご注目いただければ幸いです。